A Inteligência Artificial (IA) é definida como a simulação da inteligência humana por máquinas com a capacidade de tomar decisões e resolver problemas sem a necessidade de intervenção humana.

Embora o conceito tenha sido introduzido no século passado, na última década ele ganhou impulso graças ao poder computacional para processamento e coleta de dados que possibilitou tecnologias mais acessíveis, econômicas e rápidas para qualquer tipo de usuário.

O que é inteligência artificial generativa?

Os modelos tradicionais de IA são baseados em modelos estatísticos que se concentram no reconhecimento de padrões dos dados existentes e são mais bem utilizados em contextos analíticos e preditivos.

Com o surgimento da inteligência artificial, foi criada uma nova categoria chamada generativa, que tem o potencial de (re)construir ou (re)produzir conteúdo a partir de algum texto, imagem, vídeo, áudio ou código-fonte, tão plausível quanto o usuário permitir.

Os modelos generativos, portanto, podem produzir novos dados (artificiais) usando dados reais (alimentados pelo usuário) e criar novas informações; esse horizonte que existia até alguns anos atrás apenas em livros ou filmes de ficção científica está cada vez mais próximo da realidade.

O mecanismo no qual esses modelos generativos estão centrados para seu funcionamento correto é a técnica GAN (Generative Adversarial Networking). As GANs fazem parte da aprendizagem profunda, um ramo da aprendizagem automática que simula o comportamento dos neurônios e melhora a automação e a otimização de tarefas analíticas e criativas sem interação humana.

Embora o futuro seja promissor para cada um dos campos em que ela pode ser aplicada, e com grandes expectativas, há riscos associados à adoção dessa nova tendência.

Quais são os riscos da Inteligência Artificial Generativa?

A IA Generativa reside no ciberespaço e, consequentemente, existem riscos associados que podem afetar tanto indivíduos quanto empresas ou governos. Na ESET, identificamos 5 riscos principais e os abordaremos a seguir:

1. Moderação de conteúdo

Algumas das redes sociais, sites ou aplicativos não são legalmente responsáveis, ou são muito ambíguos, quando se trata de conteúdo carregado por seus usuários, como ideias ou postagens feitas por terceiros ou conteúdo subjacente gerado por IA: mesmo que eles tenham termos de uso, padrões da comunidade e políticas de privacidade que protejam os direitos autorais, há uma lacuna legal que protege os provedores de violação de direitos autorais.

O usuário tem acesso fácil e grande disponibilidade de ferramentas de IA Generativa que não são claras, e até mesmo contraditórias, em suas políticas de uso e implementação.

As perguntas aqui seriam: a responsabilidade seria dos criadores dessas plataformas/aplicativos de IA Generativa ou ela é transferida para os usuários que usam o conteúdo derivado delas para carregá-lo em cada uma de suas redes sociais? As redes sociais precisam começar a implementar aspectos legais que não recaiam na ambiguidade para esse tipo de conteúdo?

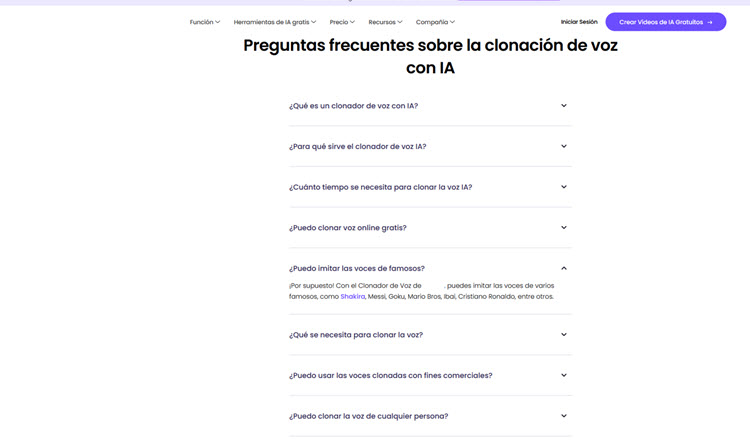

2. Violação de direitos autorais e de imagem

Nos Estados Unidos, em maio de 2023, uma nova greve do Sindicato dos Roteiristas deu início a uma série de conflitos aos quais se juntou, em julho do mesmo ano, o Sindicato dos Atores de Hollywood. As principais causas desse movimento foram a demanda por um aumento salarial devido ao aumento das redes digitais, pois houve um crescimento na demanda/criação de conteúdo e eles queriam que os lucros fossem compartilhados proporcionalmente entre roteiristas/atores e as grandes empresas.

Outro motivo foi o uso da IA Generativa por parte dessas empresas para produzir conteúdo sem o consentimento do ator/atriz para usar seu rosto e voz para fins comerciais, de modo que eles solicitaram um novo contrato para protegê-los da exploração de sua identidade e talento sem seu consentimento ou remuneração por essa tecnologia.

A originalidade de qualquer conteúdo, independentemente da fonte, com o advento da IA Geradora, parece estar ficando cada vez mais embaçada. Nesse caso, muitos direitos autorais e permissões de imagem foram ignorados por grandes empresas, gerando um enorme incômodo e, como consequência, os EUA optaram por implementar soluções legais para proteger ambas as partes.

3. Privacidade

Voltando ao que aconteceu nos EUA com atores e roteiristas, para que os modelos de IA Geradora funcionem adequadamente, eles precisam de grandes volumes de dados para serem treinados, mas o que acontece quando esse volume pode ser obtido de qualquer fonte pública, como vídeos, áudios, imagens, textos ou códigos-fonte, sem o consentimento do proprietário?

É nesse ponto que as plataformas, os aplicativos e as redes sociais devem aderir à estrutura normativa sobre privacidade de dados de cada país, como a Lei Geral de Proteção de Dados no Brasil, caso contrário, confie no Regulamento Geral de Proteção de Dados (GDPR) do Parlamento Europeu, que já inclui uma seção para IA.

4. Questões éticas

Em países onde há pouca ou nenhuma regulamentação sobre IA, alguns usuários se aproveitam dela para fins antiéticos, que vão desde a personificação (voz, imagem ou vídeo) até a criação de perfis falsos que eles usam para cometer fraude/extorsão por meio de uma plataforma, aplicativo ou rede social, bem como o lançamento de campanhas sofisticadas de phishing ou golpes de catfishing.

5. Desinformação

Ao se aproveitar desse tipo de IA, as práticas de disseminação de fake news em plataformas e redes sociais são aprimoradas. A viralização desse conteúdo falso gerado pode prejudicar a imagem de uma pessoa, comunidade, país, governo ou empresa.

Inteligência artificial generativa e os desafios nos setores industriais

Uma pesquisa realizada em 2023 pela KPMG mostrou que muitos setores acreditam que a implementação da Inteligência Artificial Generativa oferece benefícios e oportunidades interessantes, como o aumento da receita, do posicionamento e da participação no mercado. 77% acreditam que a IA generativa terá um grande impacto em seus negócios nos próximos 3 a 5 anos.

Por outro lado, os setores que mais adotaram essa tecnologia foram Tecnologia e Operações, com 56%, seguidos por Marketing (42%), Vendas (40%) e Desenvolvimento de Produtos (40%). Por outro lado, os setores que adotaram mais recentemente foram os de Recursos Humanos (16%) e Jurídico (14%).

O que está limitando a implementação dessa tecnologia nos setores?

Independentemente do setor, a pesquisa da KPMG indicou que as barreiras que os setores encontram para a adoção da IA generativa são:

- Falta de talentos qualificados para desenvolver e implementar adequadamente a IA Generativa (13%);

- Custo/falta de investimento (13%);

- Falta de um caso de negócios claro (13%);

- Falta de clareza sobre formas específicas de implementar a IA Generativa (12%);

- Falta de compreensão e/ou estratégia de liderança na adoção da nova IA Generativa (11%);

- Identificação de modelos adequados de IA geradora para o setor em que será implementada (8%);

- Riscos potenciais e/ou ameaças à privacidade dos dados que alimentam a IA Generativa (8%);

- Infraestrutura tecnológica insuficiente para dar suporte a ela (7%);

- Incapacidade de acessar/usar os dados (6%);

- Resistência cultural interna (6%);

- Exposição jurídica (3%);

- Incapacidade de executar determinadas tarefas simples e fornecer resultados autênticos e precisos, conforme exigido pela empresa (2%).

Conclusões

A IA Generativa apresenta riscos específicos que devem ser cuidadosamente tratados para garantir seu uso seguro e ético. Esses riscos, conforme descritos, vão desde a moderação do conteúdo carregado pelos usuários até o conteúdo falso, tendencioso ou prejudicial para evitar a manipulação de informações. Ao considerar esses riscos, é essencial implementar estratégias preventivas e corretivas, tais como:

- Filtragem e moderação eficazes: desenvolver sistemas robustos de filtragem e moderação que possam identificar e remover conteúdo inadequado, falso ou tendencioso gerado por modelos de IA Generativa. Isso ajudará a manter a integridade das informações e a evitar possíveis consequências negativas.

- Treinamento com dados éticos e diversificados: garantir que os modelos de IA Geradora sejam treinados com conjuntos de dados éticos, imparciais e representativos. A diversificação de dados ajuda a reduzir o viés e a melhorar a capacidade do modelo de gerar conteúdo mais justo e preciso.

- Transparência na regulamentação de conteúdo: estabelecer regulamentações que permitam aos usuários entender como o conteúdo é gerado, como os dados são tratados e as implicações da não conformidade.

- Avaliação contínua da ética e da qualidade: implementar mecanismos de avaliação contínua para monitorar a ética e a qualidade do conteúdo gerado. Esses mecanismos podem incluir auditorias regulares, testes de robustez e colaboração com a comunidade para identificar e resolver possíveis problemas éticos.

- Educação e conscientização do público: promover a educação e a conscientização do público sobre os riscos associados à IA generativa. Promover a compreensão de como esses modelos funcionam e quais são seus possíveis impactos permitirá que o usuário participe ativamente da discussão e exija práticas éticas dos desenvolvedores e das empresas.