A Inteligência Artificial Generativa está desempenhando um papel cada vez mais importante na vida pública e privada de indivíduos, governos e empresas. Ao mesmo tempo, grandes plataformas tecnológicas estão modificando e atualizando suas políticas de privacidade, de acordo com a incorporação de novas funcionalidades com essa tecnologia.

No entanto, há situações em que o uso que a inteligência artificial (IA) fará dos dados coletados não é claramente definido. Embora algumas empresas informem diretamente que os dados serão utilizados para aprimorar o modelo de treinamento da IA e melhorar seus produtos ou serviços, essa comunicação nem sempre é transparente.

O tratamento dos dados exigidos por essas tecnologias e o gerenciamento das informações para alimentá-las requerem contratos claros e objetivos, que evitem qualquer tipo de confusão ou insatisfação. Como discutido post "Os 5 principais desafios apresentados pela inteligência artificial generativa", a violação da privacidade e dos direitos autorais é um dos principais riscos associados ao uso dessa tecnologia.

Levando tudo isso em consideração, a ESET analisa os exemplos do Windows Recall e das novas políticas de uso da Adobe para avaliar como essas empresas estão gerenciando a privacidade dos dados, os riscos envolvidos nessas mudanças e a importância de uma comunicação clara e transparente para manter a confiança dos usuários e garantir a conformidade legal.

Windows Recall

Os dispositivos com PC Copilot+ contam com um recurso chamado Recall, que permite localizar e registrar tudo o que você viu e fez em sua máquina, funcionando como uma linha do tempo de conteúdo que pode ser acessada sempre que necessário.

O Recall, portanto, registra tudo o que você faz em aplicativos, comunicações e reuniões, lembra cada página da Web que você visitou, cada livro ou artigo que leu. Ele também faz capturas de tela para facilitar a identificação do conteúdo que você deseja ter disponível.

É nesse contexto que muitos usuários expressaram preocupações legítimas sobre até que ponto a IA pode invadir sua privacidade e se essas informações são enviadas para a nuvem. A Microsoft assegura que todos os dados permanecem no dispositivo, sendo armazenados localmente, e que as informações utilizadas para essa função são devidamente criptografadas.

Com base nas críticas recebidas antes de seu lançamento — já que, originalmente, o recurso não seria opcional — a Microsoft lançou o Recall com a opção de desativá-lo ou, se necessário, personalizá-lo. Os usuários podem controlar quais sites ou aplicativos o Recall monitora, excluir conteúdo específico ou até mesmo substituir a captura de tela para impedir a coleta de dados.

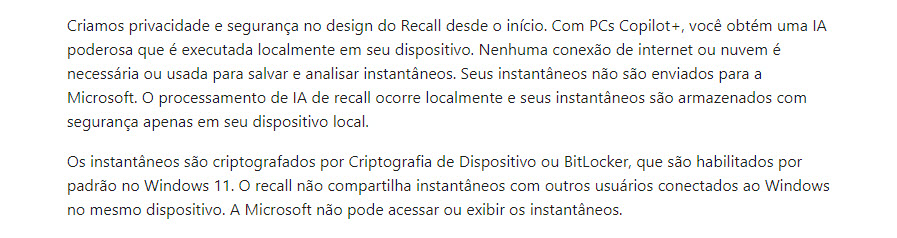

Na seção "Armazenamento de instantâneos: o conteúdo permanece local" da documentação oficial da Microsoft, consta a seguinte declaração:

En la sección de “Almacenamiento de instantáneas: el contenido permanece local” de la documentación oficial de Microsoft se indica lo siguiente:

No entanto, como veremos a seguir, a ativação de novos recursos em um sistema operacional que afetam a privacidade e facilitam o acesso do usuário pode abrir novas portas que podem ser exploradas por cibercriminosos.

Exemplo de como os cibercriminosos podem tirar proveito do Recall

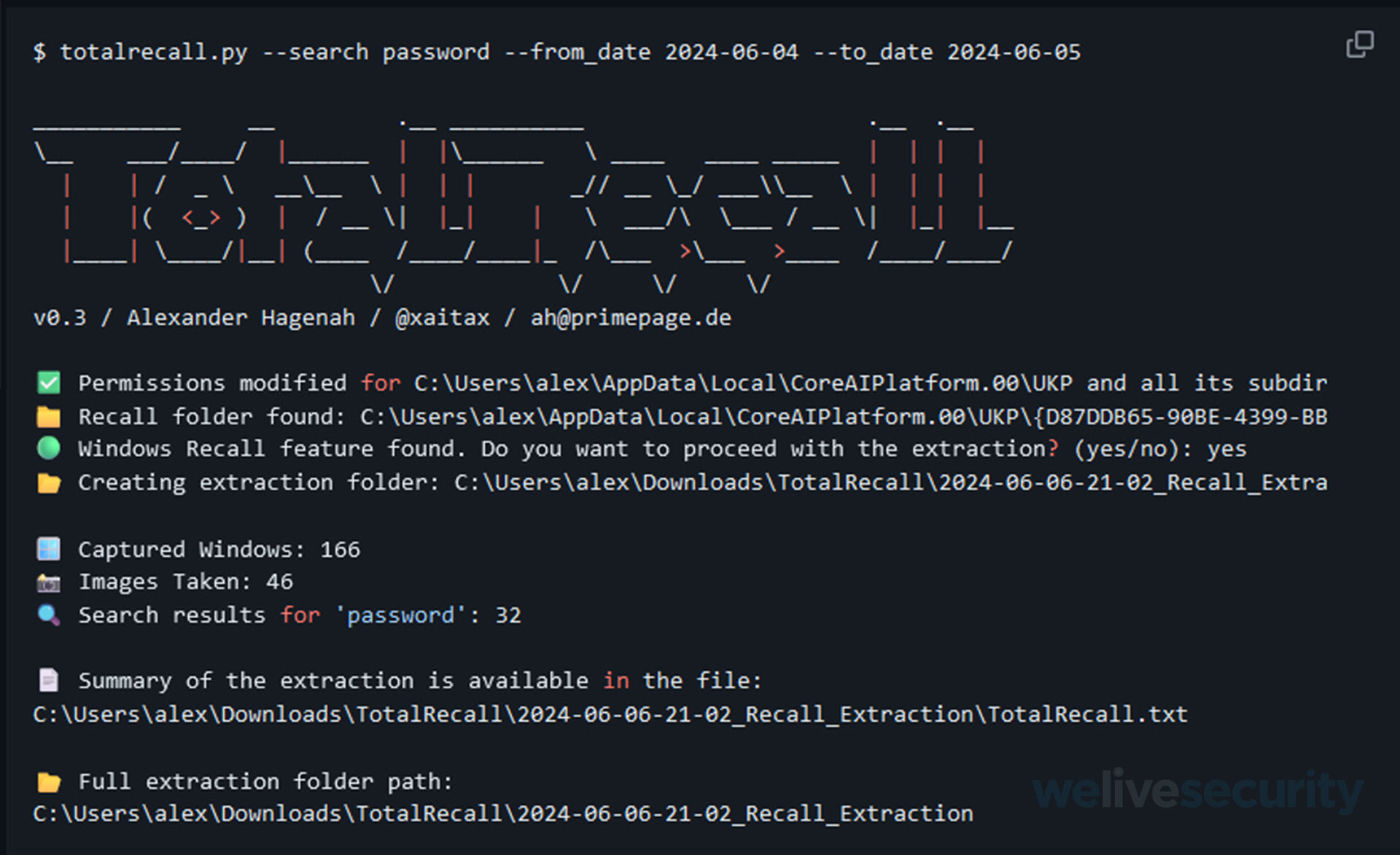

Antes do lançamento oficial do PC Copilot+, um especialista em cibersegurança demonstrou que esse recurso armazena capturas de tela em um banco de dados não criptografado. Todas as informações estão em texto simples e podem ser facilmente extraídas com uma ferramenta chamada TotalRecall.

O TotalRecall localiza o banco de dados do Recall, copiar as capturas de tela e o banco de dados para uma pasta de extração, realiza uma varredura adicional em busca de dados específicos (como senhas, termos de pesquisa, informações de cartão de crédito, etc.), e, em seguida, fornece um resumo desses dados em questão de segundos.

Um cibercriminoso pode obter uma enorme quantidade de informações valiosas sobre sua vítima, incluindo seus e-mails, conversas pessoais e qualquer informação capturada pelo Recall. É importante mencionar que o banco de dados principal do Recall é armazenado no diretório do sistema do dispositivo e o acesso a ele requer permissões de administrador; no entanto, um invasor pode empregar várias técnicas para elevar os privilégios, o que teoricamente torna possível a exfiltração de dados.

A linha tênue entre privado e invasivo: Adobe e sua nova política de uso

A Adobe é uma das principais empresas de desenvolvimento de software, amplamente adotada pelos setores público e privado ao longo dos anos. Com qualquer evolução, é essencial que existam políticas de uso que previnam a aplicação antiética de seus produtos. Por isso, é crucial ter uma linguagem clara e precisa em todas as áreas, pois novas políticas podem ser mal interpretadas e gerar insatisfação entre os usuários.

Em fevereiro de 2024, a Adobe introduziu uma nova política de uso que afirmava que, para continuar usando seus produtos, os usuários eram obrigados a aceitá-la, algo que, à primeira vista e devido à forma como foi apresentada, causou discordância e preocupação entre a comunidade.

Diante dessa situação, o diretor do produto Substance 3D precisou esclarecer que nenhum projeto dos usuários seria acessado ou lido. Ele destacou que isso seria inútil e que todas as empresas do setor abandonariam imediatamente a Adobe se fosse esse o caso.

A intenção de moderar o conteúdo que é gerado nos diversos produtos da Adobe é uma excelente iniciativa, no entanto, a redação e as limitações desse acesso foram muito vagas ou pouco claras, apesar do exposto, a Adobe indicou que está sujeita ao Regulamento Geral de Proteção de Dados (GDPR) do Parlamento Europeu.

Outra circunstância que gerou insatisfação entre os usuários antes da atualização de 18 de junho deste ano foi a seção "C", onde a Adobe Creative Cloud exigia acesso ao conteúdo do usuário para analisá-lo e treinar seus algoritmos de aprendizado de máquina (Firefly Gen AI), com o objetivo de melhorar seus serviços.

Ao se dar conta desses fatos, a Adobe teve que atualizar e incorporar resumos com informações mais detalhadas e o motivo pelo qual os dados seriam acessados.

Para a seção "Privacidade" na seção 2.2 "Nosso acesso ao seu conteúdo", a Adobe deixou mais claro que você é o proprietário do seu conteúdo, mas que precisa acessá-lo conforme necessário para o funcionamento adequado de seus aplicativos e serviços.

O objetivo de revisar o conteúdo do usuário é "detectar certos tipos de conteúdo ilegal, como material de abuso sexual infantil, ou outro conteúdo ou comportamento abusivo, como padrões de atividade que indicam spam ou phishing", conforme afirma a Adobe. A empresa oferece aos usuários a capacidade de revisar se o conteúdo criado é ilegal ou abusivo.

Um dos destaques da nova atualização é que a Adobe afirma que "NÃO" verifica "NEM" analisa o conteúdo local no dispositivo onde seus produtos estão sendo usados. Apenas o conteúdo público e compartilhado nas comunidades Adobe Stock, Behance e Lightroom estará sujeito à revisão mencionada, por motivos de propriedade intelectual e segurança. Além disso, o treinamento dos modelos de IA generativa (Firefly Gen AI) não utilizará o conteúdo do usuário, a menos que este esteja disponível publicamente no Adobe Stock.

Conclusão

A importância dos novos recursos sempre agrega valor aos fabricantes ou desenvolvedores, mas eles devem ser acompanhados de termos de uso e políticas que utilizem uma linguagem clara, em vez de ambígua ou excessivamente legalista. Dessa forma, é possível garantir:

- Acessibilidade e compreensibilidade: uma linguagem clara e direta permite que um público mais amplo compreenda facilmente os termos e condições e os novos recursos, o que aumenta a transparência e a acessibilidade das informações. Em contrapartida, somente uma linguagem mais técnica pode atender aos requisitos legais e equilibrar a proteção jurídica, mas é preciso ter em mente que ela deve ser clara e concisa para que os usuários entendam seus direitos e obrigações.

- Confiança do usuário: a clareza na comunicação reduz a percepção de que os fabricantes ou desenvolvedores estão tentando esconder algo ou complicar desnecessariamente os termos.

- Redução de conflitos: termos e condições claros podem ajudar a evitar mal-entendidos e disputas entre os usuários e a plataforma. Se os usuários entenderem completamente com o que estão concordando, é menos provável que surjam disputas legais e a necessidade de intervenções jurídicas dispendiosas é reduzida.

Quando novas funções ou recursos são explicados de forma simples, os usuários podem adotá-los e usá-los com mais eficiência. Uma compreensão clara de como os novos recursos funcionam pode melhorar a experiência do usuário e aumentar a satisfação. A transparência e a clareza na comunicação contribuem positivamente para a imagem dos fabricantes ou desenvolvedores. Em ambos os casos, aqueles que se esforçam para ser claros e diretos em sua comunicação são vistos como mais honestos e responsáveis no tratamento dos dados de seus usuários.