Desde que os algoritmos de inteligência artificial generativa deixaram os laboratórios universitários e se tornaram uma ferramenta acessível a qualquer usuário, diversos benefícios surgiram. No entanto, os cibercriminosos também conseguiram tirar proveito disso, e os deepfakes se tornaram uma das grandes dores de cabeça no mundo da cibersegurança.

A geração de imagens, vídeos ou áudios falsificados para aplicar golpes, roubar informações ou desestabilizar a opinião pública é uma prática comum no universo do cibercrime.

A equipe de pesquisa da ESET descobriu uma campanha nas redes sociais que utiliza avatares criados com IA para se fazer passar por profissionais da área da saúde, com o objetivo de promover a compra de suplementos e outros produtos, fazendo com que pareçam recomendações médicas legítimas.

Como o golpe funciona

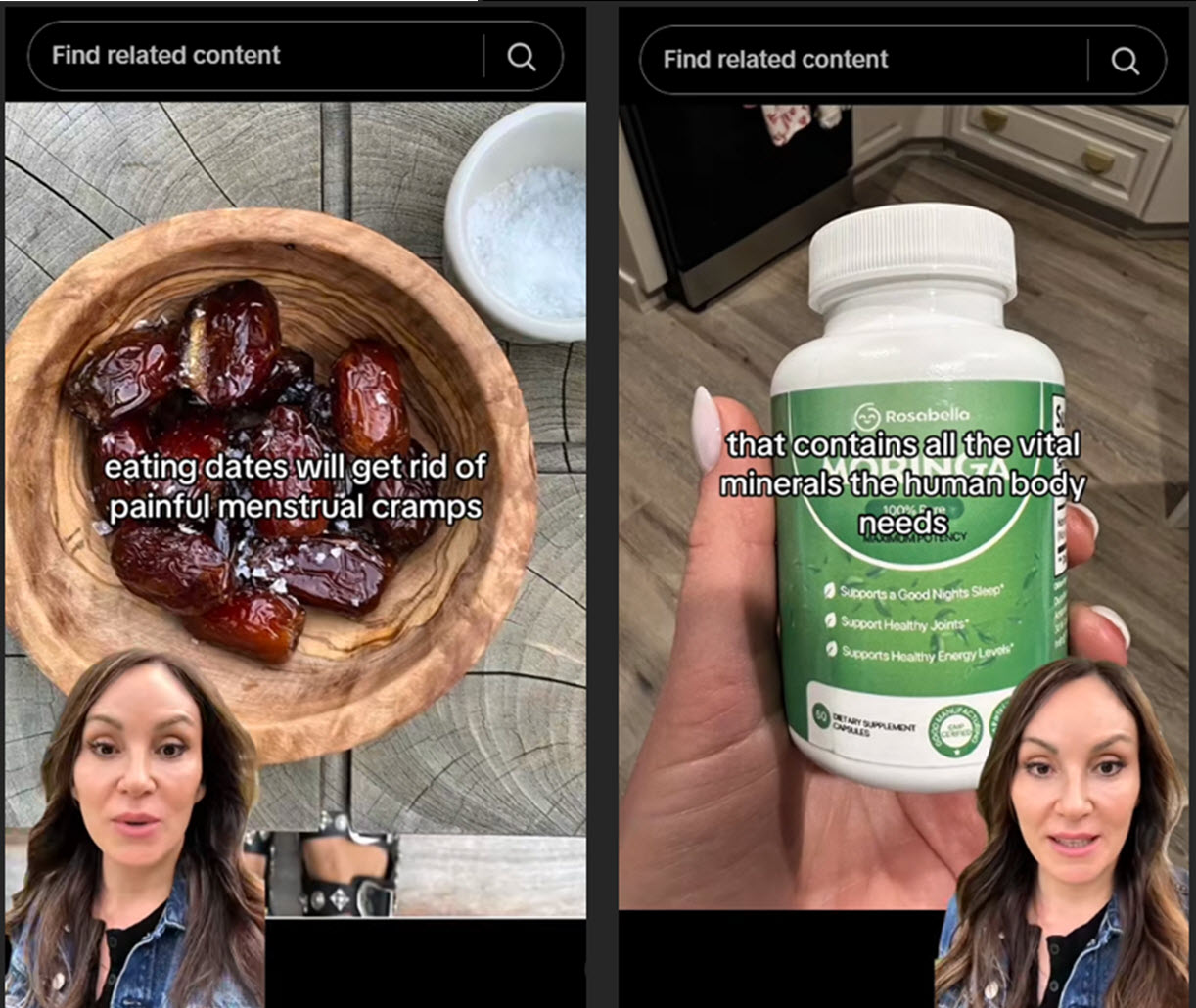

Os vídeos analisados seguem uma estrutura bastante definida: no formato de "avatar" em um canto da tela, uma pessoa que afirma ser especialista com mais de uma década de experiência apresenta uma série de recomendações de estética e saúde. As dicas, geralmente relacionadas à alimentação natural, induzem à compra de produtos que estão sendo vendidos.

Eles utilizam uma estratégia de marketing desleal, tentando gerar uma validação falsa de supostos especialistas para fazer o público acreditar que a mensagem está sendo transmitida por alguém com conhecimento no assunto.

Também foram observados casos em que são promovidos medicamentos sem aprovação oficial e são oferecidas dicas falsas para problemas de saúde graves, utilizando deepfakes com a imagem de profissionais amplamente reconhecidos.

Desinformação e golpe

Como exemplo dos vídeos encontrados, uma dessas contas promove um extrato natural que afirma ser mais eficaz do que o Ozempic - que recentemente se tornou popular por seu efeito colateral de perda de peso.

O golpe está no fato de que o link fornecido no perfil do TikTok direciona para a plataforma da Amazon para comprar o suposto produto emagrecedor, mas, na realidade, o item final é descrito como "gotas relaxantes" e "anti-inchaço", sem nenhuma menção aos supostos grandes benefícios apresentados no vídeo.

Um aplicativo que facilita a criação de identidades falsas

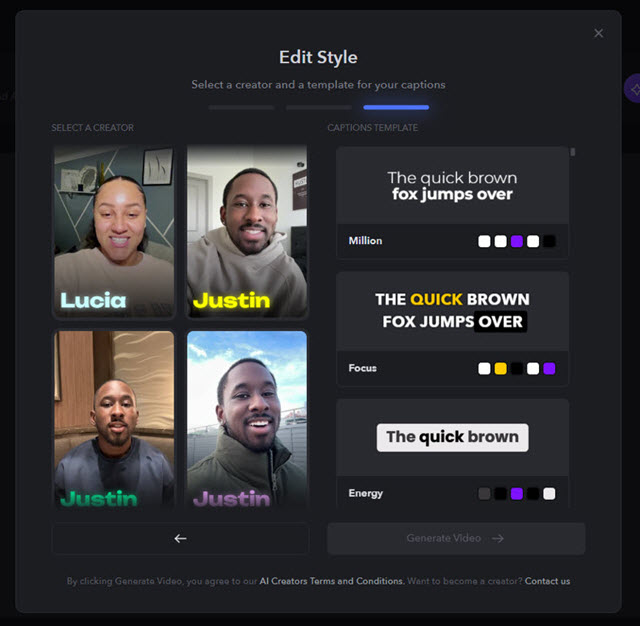

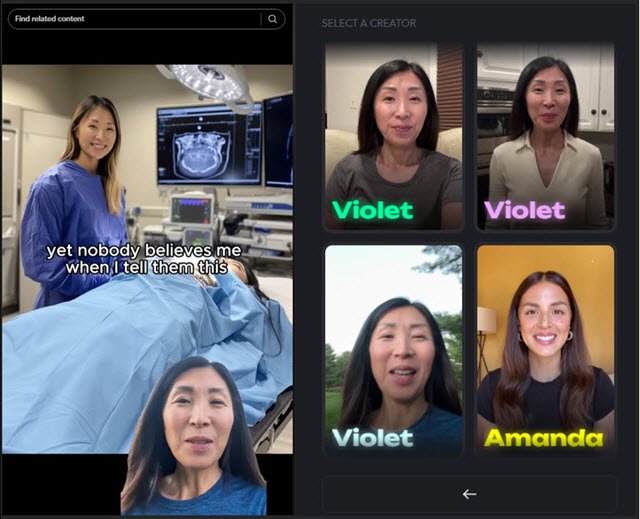

Neste levantamento, identificamos mais de 20 contas com esse tipo de conteúdo, distribuídas nas plataformas preferidas para vídeos curtos: Instagram e TikTok. Os avatares são criados com o uso do aplicativo Captions, uma plataforma de geração de conteúdo que utiliza inteligência artificial.

De fato, é possível identificar na lista todos os supostos profissionais de saúde que aparecem nos vídeos suspeitos. Um exemplo é o caso de uma falsa ginecologista que alega ter mais de 13 anos de experiência:

Esses avatares fazem parte de um programa chamado "AI Creator", no qual influenciadores e criadores de conteúdo podem se oferecer como protagonistas desses vídeos gerados artificialmente e ganhar dinheiro com isso - basta gravar alguns clipes de poucos minutos e enviá-los para a plataforma.

E, embora esse tipo de vídeo represente uma violação dos Termos e Condições do aplicativo, isso também deve servir de alerta para criadores de conteúdo que estejam considerando se inscrever nesse tipo de programa remunerado.

Em tempos de desinformação de fácil disseminação, é fundamental saber reconhecer esse tipo de golpe ou publicidade infundada. Por isso, devemos ficar atentos a sinais de que se trata de um conteúdo falso, como:

- Descompasso entre boca e áudio, com movimentos labiais que não coincidem perfeitamente com a fala.

- Expressões faciais pouco naturais ou rígidas.

- Falhas visuais e distorções, como bordas borradas ou mudanças repentinas de iluminação.

- Voz robótica, artificial ou com entonação muito uniforme.

- Perfis recém-criados, com poucos seguidores ou sem histórico relevante.

- Linguagem exagerada, com frases como "cura milagrosa", "os médicos não querem que você saiba" ou "100% garantido".

- Afirmações sem respaldo científico, ou baseadas em estudos e fontes de baixa credibilidade.

- Apelos à urgência e pressão para comprar, com frases como "só por tempo limitado" ou "últimas unidades disponíveis".

Caso encontre esse tipo de conteúdo, é essencial não compartilhar nem acreditar sem antes verificar a origem e o propósito das informações apresentadas nos vídeos. Além disso, se identificar um conteúdo enganador, denuncie a publicação diretamente na rede social em que ela aparece.