siLa Inteligencia Artificial generativa juega un papel cada vez más importante en la vida pública y privada de las personas, gobiernos y empresas. A la vez, las grandes plataformas tecnológicas modifican y actualizan sus políticas de privacidad, al compás de la incorporación de nuevas funcionalidades con esta tecnología.

Sin embargo, hay casos en los que está poco claro el tratamiento que la inteligencia artificial dará a los datos recopilados, aunque algunas empresas directamente advierten que estos serán usados para mejorar el modelo de entrenamiento de Inteligencia Artificial, con el fin de mejorar sus productos o servicios.

El manejo de los datos que requieren estas tecnologías y la administración de la información para nutrirla, hace necesario contratos que sean claros y concisos, que no presten a confusión o descontento. Tal como presentamos en el post 5 principales desafíos que impone la inteligencia artificial generativa, la violación de la privacidad y los derechos de autor son uno de los principales riesgos que puede acarrear el uso de esta tecnología.

En torno a estos interrogantes, desde ESET analizamos los ejemplos de Windows Recall y las nuevas políticas de uso de Adobe, através de los que evaluaremos cómo estas empresas están gestionando la privacidad de los datos, los riesgos que estos cambios implican y la importancia de una comunicación clara y transparente para mantener la confianza de los usuarios y asegurar el cumplimiento legal.

Windows Recall

Aquellos equipos que cuenten con PC Copilot+ tendrán una función llamada Recall que permitiría encontrar y recordar todo lo visto y hecho en la PC —como si se tratara de una línea del tiempo del contenido a la que puede accederse cuando más se necesite.

Recall, entonces, registra todo lo que se hace en las aplicaciones, las comunicaciones y reuniones, recuerda todas las páginas web que se hayan visitado, todos los libros o artículos leídos. También toma capturas de pantallas para poder identificar más fácil el contenido del que se quiere disponer.

He aquí donde muchos usuarios han mostrado una preocupación genuina de hasta dónde puede utilizarse la IA para invadir su privacidad y si dicha información es enviada a la nube. Aunque Microsoft asegura que todo se queda en la misma PC, almacenada localmente y, además, que los datos para esta función están debidamente cifrados.

En base a las críticas que había recibido antes de su lanzamiento —ya que en principio no iba a poder ser opcional— Microsoft lanzó Recall con la posibilidad desactivarlo o, por caso, personalizarlo y controlar qué sitios web o aplicaciones puede excluir, borrar contenidos o incluso anular totalmente la captura de pantallas para inhabilitar la recolección de información.

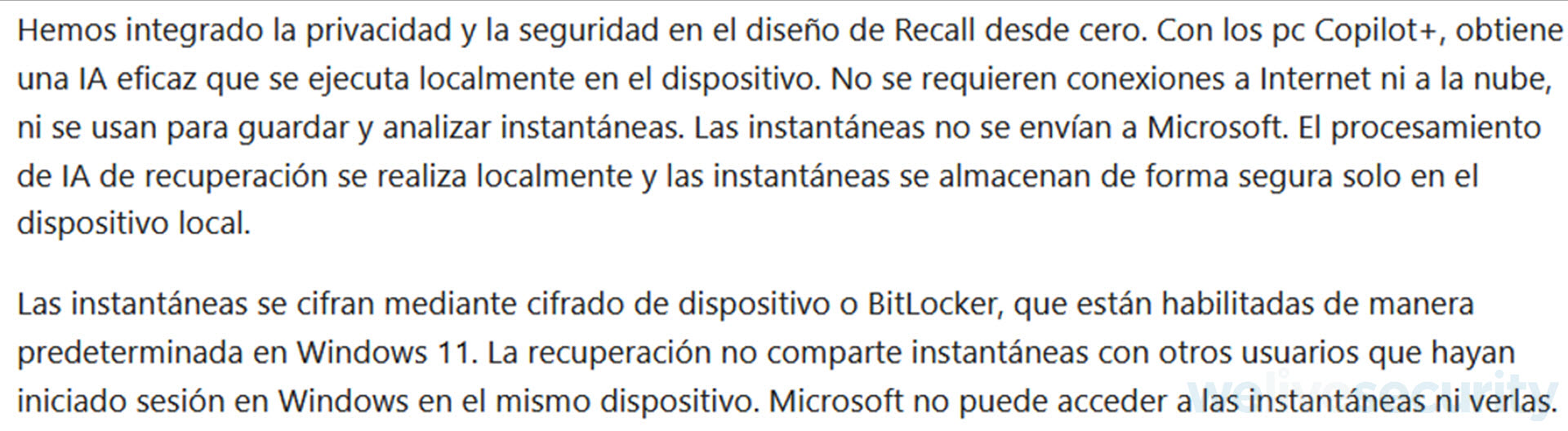

En la sección de “Almacenamiento de instantáneas: el contenido permanece local” de la documentación oficial de Microsoft se indica lo siguiente:

Sin embargo, como veremos a continuación, cuando se habilitan nuevas características a un sistema operativo que involucren la privacidad del usuario y faciliten su acceso, esto trae consigo nuevas puertas que pueden ser aprovechados por los ciberdelincuentes.

Una muestra de cómo los cibercriminales pueden sacar provecho de Recall

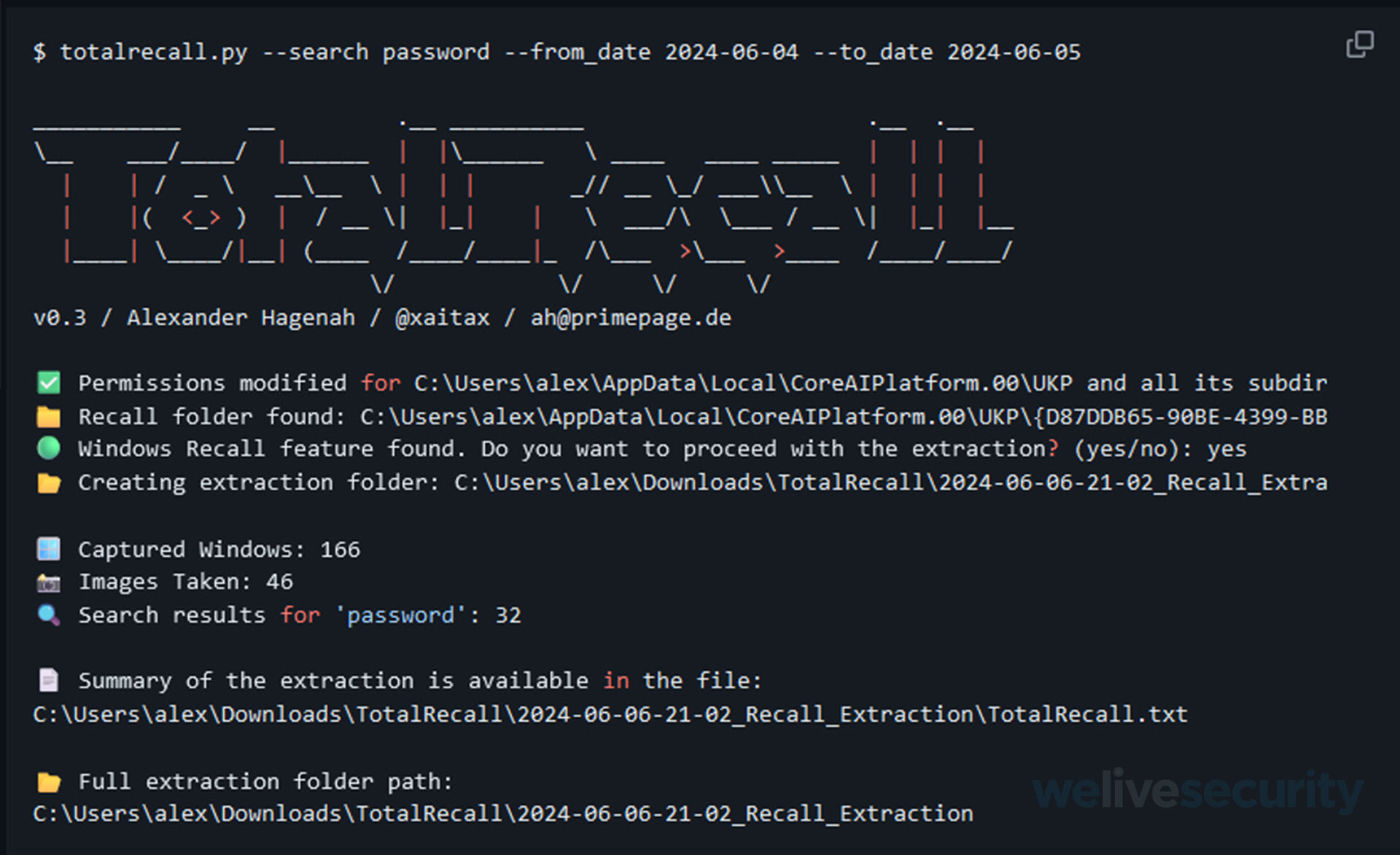

Previo al lanzamiento oficial de PC Copilot+, un entusiasta de la ciberseguridad demostró que esta función almacena las capturas de pantalla en una base de datos sin cifrar, todo se encuentra en texto plano y puede ser extraído de una manera muy sencilla con una herramienta llamada TotalRecall.

Lo que hace TotalRecall es que encuentra la base de datos de Recall, copia las capturas de pantalla tomadas y la base de datos en una carpeta de extracción, además analiza las bases de datos en busca de datos especificados por el usuario (por ejemplo, contraseñas, términos de búsqueda, información de tarjetas de crédito, etc.) y luego entrega un resumen que incluye esos datos en cuestión de segundos.

Un ciberdelincuente podría obtener una enorme cantidad de información valiosa sobre su víctima, incluyendo sus correos electrónicos, conversaciones personales y cualquier información capturada por Recall. Es importante mencionar que la base de datos principal de Recall es almacenada en el directorio del sistema de la PC y para acceder a ella se necesitan permisos de administrador, no obstante, un atacante puede emplear distintas técnicas para elevar privilegios lo que hace teóricamente posible una exfiltración de datos.

La línea delgada entre lo privado y lo invasivo: Adobe y su nueva política de uso

Adobe es una de las más importantes compañías desarrolladoras de software que, con el paso de los años, ha tenido una evolución y gran adopción por parte de los sectores públicos y privados; como toda evolución deben existir políticas de uso que busquen evitar la aplicación de sus diferentes productos para fines nada éticos. Por eso es relevante tener un lenguaje claro para todo tipo de ámbito, pues al momento de emitir nuevas políticas, se puede llegar a malinterpretar y generar un descontento por parte de los usuarios.

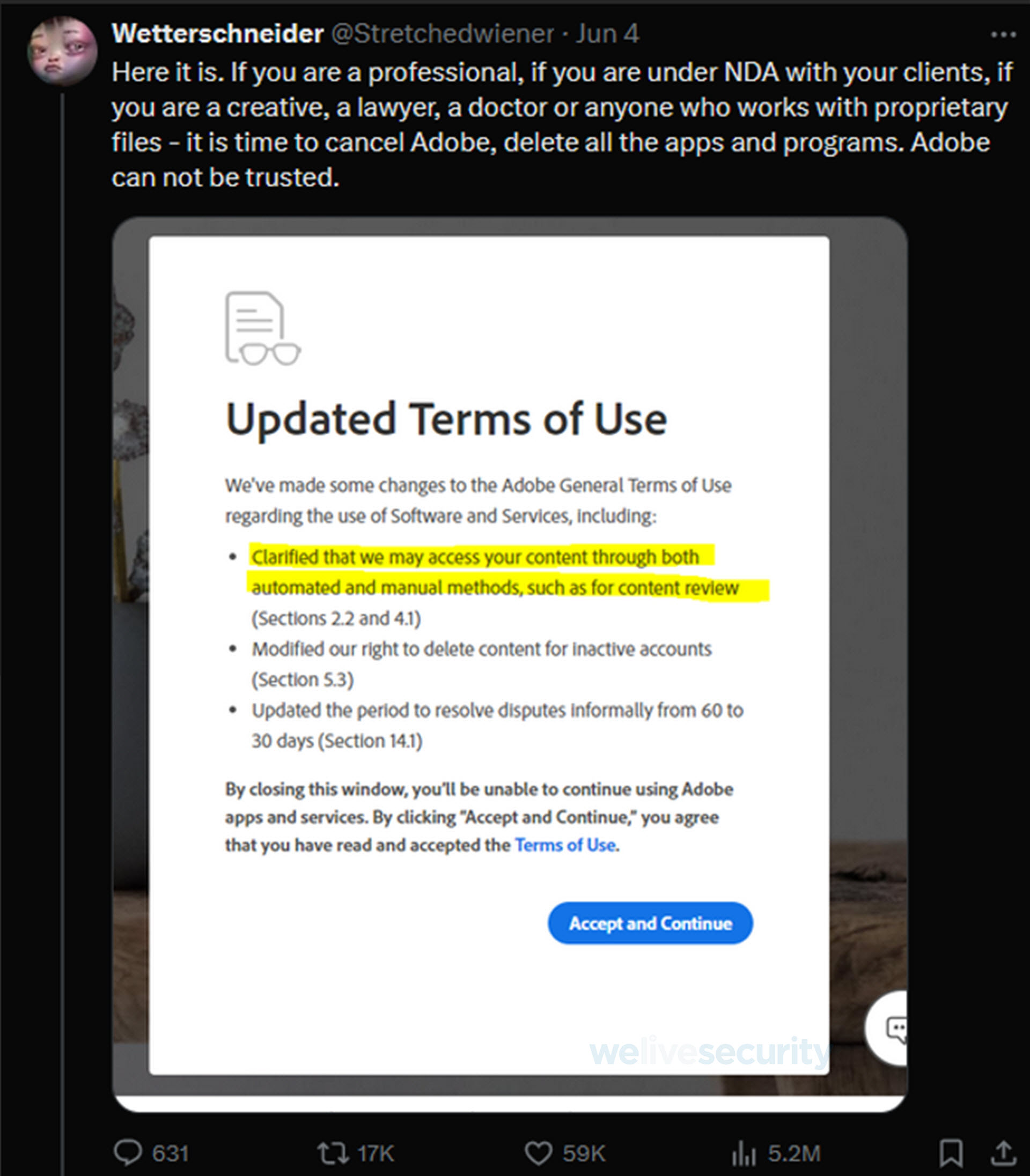

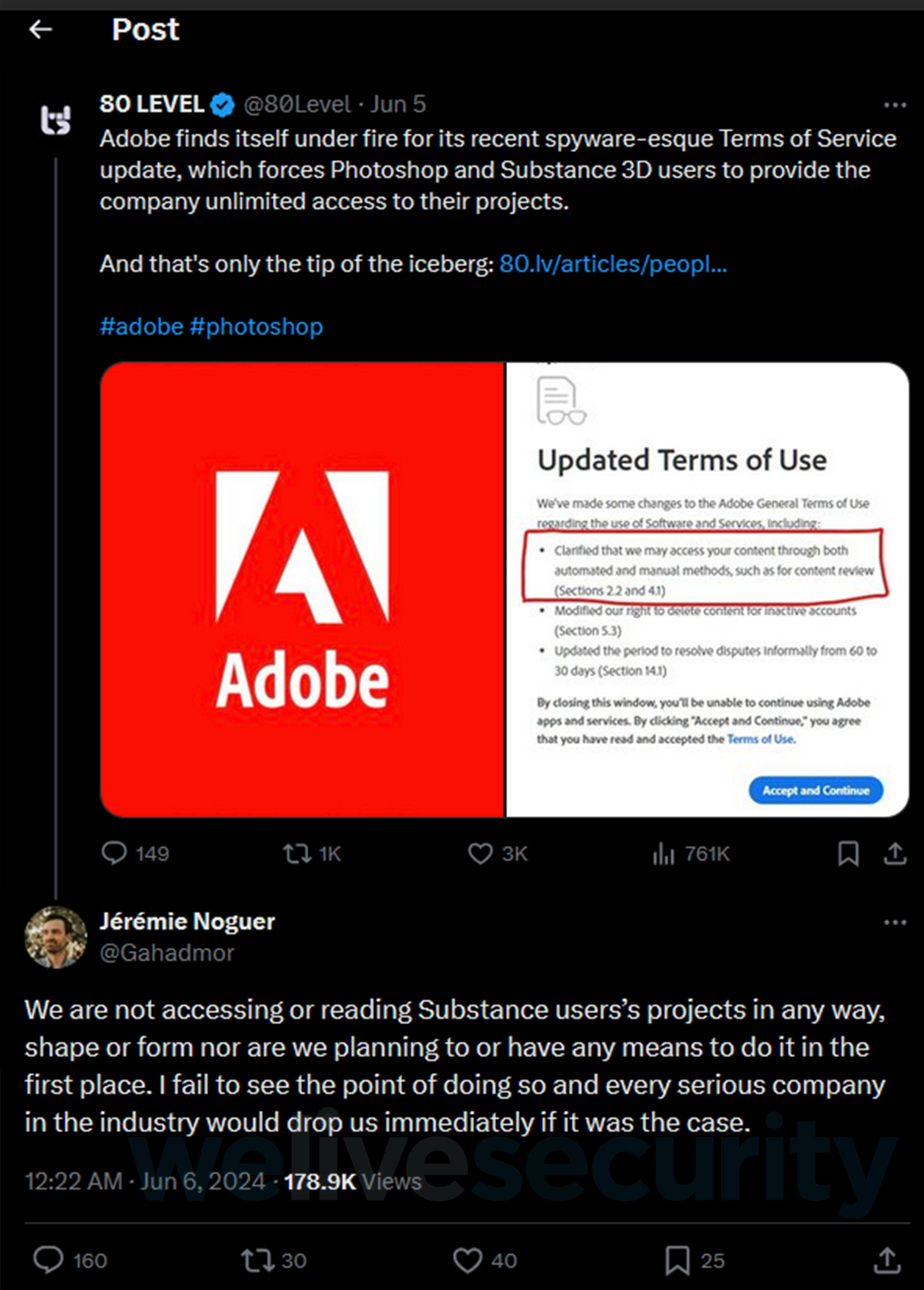

Adobe introdujo en febrero 2024 una nueva política de uso que planteaba que, para poder seguir utilizando sus productos, los usuarios estaban obligados a darle aceptación, algo que en una primera vista y por la forma en cómo se presentó causó inconformidad y preocupación por la comunidad.

Imagen. Usuario no conforme con la nueva política de uso de Adobe. Fuente. X.

Antes esta situación, el director del producto Substance 3D tuvo que salir a explicar que no se accedería o leería ningún proyecto de sus usuarios, añadiendo que no tendría sentido hacerlo y que todas las empresas de la industria los abandonarían inmediatamente si fuera el caso.

Imagen. Jérémie Nogue director de Substance 3D indicando que su política de uso no es invasiva. Fuente: X.

La intención de moderar el contenido que se genera en los diversos productos de Adobe es una excelente iniciativa, sin embargo, la redacción y limitaciones de este acceso eran muy difusas o poco claras, a pesar de lo anterior, Adobe indicó que está sujeto al Reglamento General de Protección de Datos (RGPD) del Parlamento Europeo.

Otra circunstancia que generó descontento a los usuarios previamente a su actualización el 18 de junio de este año, era en el apartado “C”, donde Adobe Creative Cloud requería de un acceso al contenido del usuario para poder analizarlo y entrenar sus algoritmos de machine learning (Firefly Gen AI), con el fin de mejorar sus servicios.

Al darse cuenta de estos hechos, Adobe tuvo que actualizar e incorporar resúmenes con información que fuera más detallada y el motivo para cuál se accederían a los datos.

Para la sección de “Privacidad” en la sección 2.2 “Nuestro acceso a su contenido” por parte de Adobe se deja más claro que el usuario es el propietario de su contenido, pero que se necesita acceder a este según sea necesario para el correcto funcionamiento de sus aplicaciones y los servicios.

La finalidad de revisar el contenido de los usuarios es para “detectar ciertos tipos de contenido ilegal, como material de abuso sexual infantil, u otro contenido o comportamiento abusivos, por ejemplo, patrones de actividad que indican correo no deseado (spam) o suplantación de identidad (phishing)” menciona Adobe, dándole al usuario la posibilidad de revisar si el contenido creado es ilegal o abusivo.

De los puntos más destacados en la nueva actualización son aquellos donde se indican que “NO” exploran “NI” revisan el contenido local del dispositivo donde se estén usando sus productos. Solo aquel contenido que sea público y compartido en el Adobe Stock o comunidades de Behance y Lightroom estará sujeto a la revisión antes mencionada por motivos de propiedad intelectual y seguridad. Seguido de que el entrenamiento de sus modelos de IA generativa (Firefly Gen AI) no usarán el contenido de los usuarios a menos que se encuentren de forma pública en Adobe Stock.

Conclusión

La importancia de nuevas funciones siempre le dará un valor agregado a los fabricantes o desarrolladores, estas siempre deben de venir con términos de uso y políticas que utilicen un lenguaje claro, en lugar de ambiguo o demasiado legalista. De esta forma pueden asegurar:

- Accesibilidad y comprensión: Un lenguaje claro y directo permite que una mayor audiencia comprenda fácilmente las condiciones y las nuevas funciones, lo que aumenta la transparencia y la accesibilidad de la información. Considerando también que, en contraposición, que solo un lenguaje más técnico puede cumplir con los requisitos legales y balancear la protección legal, pero debe tenerse en vista que debe ser claro y conciso para que los usuarios entiendan sus derechos y obligaciones.

- Confianza del usuario: La claridad en la comunicación reduce la percepción de qué fabricantes o desarrolladores están tratando de ocultar algo o de complicar innecesariamente los términos.

- Reducción de conflictos: Términos y condiciones claros pueden ayudar a prevenir malentendidos y disputas entre los usuarios y la plataforma. Si los usuarios comprenden completamente lo que están aceptando, es menos probable que surjan conflictos legales y se reduce la necesidad de intervenciones legales costosas.

Cuando las nuevas funciones o características se explican de manera sencilla, los usuarios pueden adoptar y utilizarlas de manera más efectiva. Un entendimiento claro de cómo funcionan las nuevas características puede mejorar la experiencia del usuario y aumentar la satisfacción. La transparencia y la claridad en la comunicación contribuyen positivamente a la imagen de los fabricantes o desarrolladores. Para ambos casos, aquellas que se esfuerzan por ser claras y directas en su comunicación son vistas como más honestas y responsables en el tratado de los datos de sus usuarios.